Еще никогда проблема хранения файлов не стояла так остро, как сегодня.

Появление жестких дисков объемом в 3 и даже 4ТБ, Blu-Ray дисков емкостью от 25 до 50ГБ, облачных хранилищ - не решает проблему. Вокруг нас становится все больше устройств, порождающих тяжеловесный контент вокруг: фото и видео-камеры, смартфоны, HD-телевидение и видео, игровые консоли и т.п. Мы генерируем и потребляем (в основном из интернета) сотни и тысячи гигабайт.

Это приводит к тому, что на компьютере среднестатистического пользователя хранится огромное количество файлов, на сотни гигабайт: фотоархив, коллекция любимых фильмов, игр, программ, рабочие документы и т.д.

Это все нужно не просто хранить, но и уберечь от сбоев и прочих угроз.

Псевдо-решения проблемы

Можно оснастить свой компьютер емким жестким диском. Но в этом случае встает вопрос: как и куда архивировать, скажем, данные с 3-терабайтного диска?!

Можно поставить два диска и использовать их в режиме RAID «зеркало» или просто регулярно выполнять резервное копирование с одного на другой. Это тоже не лучший вариант. Предположим, компьютер атакован вирусами: скорее всего, они заразят данные на обеих дисках.

Можно хранить важные данные на оптических дисках, организовав домашний Blu-Ray архив. Но пользоваться им будет крайне неудобно.

Сетевое хранилище - решение проблемы! Отчасти…

Network attached storage (NAS) - сетевое файловое хранилище. Но можно объяснить еще проще:

Предположим, у вас дома два или три компьютера. Скорее всего, они подключены к локальной сети (проводной или беспроводной) и к интернету. Сетевое хранилище - это специализированный компьютер, который встраивается в вашу домашнюю сеть и подключается к интернету.

В результате этого - NAS может хранить какие-либо Ваши данные, а вы можете получать к нему доступ с любого домашнего ПК или ноутбука. Забегая вперед, стоит сказать, что локальная сеть должна быть достаточно современной для того, чтобы вы могли быстро и без проблем «прокачивать» по ней десятки и сотни гигабайт между сервером и компьютерами. Но об этом - позже.

Где взять NAS?

Способ первый: покупка. Более-менее приличный NAS на 2 или 4 жестких диска можно купить за 500-800 долларов. Такой сервер будет упакован в небольшой корпус и готов к работе, что называется, «из коробки».

Способ первый: покупка. Более-менее приличный NAS на 2 или 4 жестких диска можно купить за 500-800 долларов. Такой сервер будет упакован в небольшой корпус и готов к работе, что называется, «из коробки».

Однако, ПЛЮС к этим 500-800 долларов добавляется еще стоимость жестких дисков! Так как обычно NAS продаются без них.

Плюсы: вы получаете готовое устройство и тратите минимум времени.

Минусы такого решения: NAS стоит как настольный компьютер, но при этом обладает несравнимо меньшими возможностями. Фактически это просто сетевой внешний диск за большие деньги. За довольно большие деньги вы получаете ограниченный, невыгодный набор возможностей.

Мое решение: самостоятельная сборка!

Это намного дешевле покупки отдельного NAS, хоть и чуть дольше ведь вы собираете машину самостоятельно). Однако, вы получаете полноценный домашний сервер, который при желании можно использовать во всем спектре его возможностей.

ВНИМАНИЕ! Я настоятельно не рекомендую собирать домашний сервер, используя старый компьютер или старые, отработавшие свое комплектующие. Не забывайте, что файловый сервер - это хранилище ваших данных. Не поскупитесь сделать его максимально надежным, чтобы в один прекрасный день все ваши файлы не «сгорели» вместе с жесткими дисками, например, из-за сбоя в цепи питания системной платы…

Итак, мы решили собрать домашний файловый сервер. Компьютер, жесткие диски которого доступны в домашней локальной сети для использования. Соответственно, нам нужно чтобы такой компьютер был экономичным в плане энергопотребления, тихим, компактным, не выделял много тепла и обладал достаточной производительностью.

Идеальным решением исходя из этого является системная плата со встроенным в нее процессором и пассивным охлаждением, компактных размеров.

Я выбрал системную плату ASUS С-60M1-I . Она была куплена в интернет-магазине dostavka.ru:

В комплекте поставки качественное руководство пользователя, диск с драйверами, наклейка на корпус, 2 кабеля SATA и задняя панель для корпуса:

ASUS, как впрочем и всегда, укомплектовал плату очень щедро. Полные спецификации платы вы можете узнать здесь: http://www.asus.com/Motherboard/C60M1I/#specifications . Я скажу лишь о некоторых важных моментах.

При стоимости всего в 3300 рублей - она обеспечивает 80% всего того, что нам нужно для сервера.

На борту платы находится двухъядерный процессор AMD C-60 со встроенным графическим чипом. Процессор имеет частоту 1 ГГц (автоматически может увеличиваться до 1,3 ГГц). На сегодня он устанавливается в некоторые нетбуки и даже ноутбуки. Процессор класса Intel Atom D2700. Но всем известно, что Atom имеет проблемы с параллельными вычислениями, что часто сводит его производительность на «нет». А вот C-60 - лишен этого недостатка, и в добавок оснащен довольно мощной для этого класса графикой.

В наличии два слота для памяти DDR3-1066 , с возможностью установки до 8 ГБ памяти.

Плата содержит на борту 6 портов SATA 6 Гбит . Что позволяет подключить к системе целых 6 дисков(!), а не только 4, как в обычном NAS для дома.

Что САМОЕ важное - плата построена на базе UEFI , а не привычного нам BIOS. Это значит, что система сможет нормально работать с жесткими дисками более 2,2 ТБ. Она «увидит» весь их объем. Системные платы на BIOS не могут работать с жесткими дисками более 2,2 ГБ без специальных «утилит-костылей». Разумеется, использование такого рода утилит недопустимо, если мы ведем речь о надежности хранения данных и о серверах.

С-60 довольно холодный процессор, поэтому он охлаждается с помощью одного только алюминиевого радиатора. Этого достаточно, чтобы даже в момент полной загрузки температура процессора не повышалась более 50-55 градусов. Что является нормой.

Набор портов вполне стандартный, огорчает только отсутствие нового USB 3.0. А особо хочется ответить наличие полноценного гигабитного сетевого порта:

На эту плату я установил 2 модуля по 2 ГБ DDR3-1333 от Patriot:

Система Windows 7 Ultimate устанавливалась на жесткий диск WD 500GB Green, а для данных я приобрел HDD Hitachi-Toshiba на 3 ТБ:

Все это оборудование у меня питается от БП FSP на 400 Ватт, что, разумеется - с запасом.

Финальным этапом была сборка всего этого оборудования в корпус mini-ATX.

Сразу после сборки я установил на компьютер Windows 7 Ultimate (установка заняла порядка 2 часов, что нормально, учитывая низкое быстродействие процессора).

После всего этого я отключил от компьютера клавиатуру, мышь и монитор. Фактически, остался один системный блок подключенный к локальной сети по кабелю.

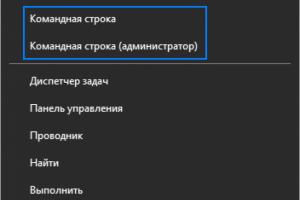

Достаточно запомнить локальный IP этого ПК в сети, чтобы подключатся к нему с любой машины через стандартную Windows-утилиту «Подключение к удаленному рабочему столу»:

Я намеренно не стал устанавливать специализированные операционные системы для организации файлового хранилища, типа FreeNAS. Ведь в таком случае, не было бы особого смысла собирать отдельный ПК под эти нужды. Можно было бы просто купить NAS.

А вот отдельный домашний сервер, который можно загрузить работой на ночь и оставить - это интереснее. К тому же, привычным интерфейсом Windows 7 удобно управлять.

Итого общая стоимость домашнего сервера БЕЗ жестких дисков составила 6 000 рублей.

Важное дополнение

При использовании любого сетевого хранилища очень важна пропускная способность сети. Причем, даже обычная 100 Мегабитная кабельная сеть не приводит в восторг, когда вы, скажем, выполняете архивацию со своего компьютера на домашний сервер. Передать 100 ГБ по 100 Мегабитной сети - это уже несколько часов.

Что уж говорить о Wi-Fi. Хорошо, если вы используете Wi-Fi 802.11n - в этом случае скорость сети держится в районе 100 Мегабит. А если стандарт 802.11g, где скорость редко бывает больше 30 Мегабит? Это очень, очень мало.

Идеальный вариант, когда взаимодействие с сервером происходит по кабельной сети Gigabit Ethernet . В этом случае - это действительно быстро.

Но о том, как создать такую сеть быстро и с минимальными затратами - я расскажу в отдельной статье.

Сегодня, уважаемый читатель, мы поговорим о том, как же можно соорудить сервер из домашнего компьютера.

Как не странно, но если вы читали статью о , то вы уже умете хостить сайты на своем домашнем компьютере. Оказывается, все что нужно для того, чтобы сайт грузился не с какого-то сервера хостинг-провайдера, а со своего знакомого родного домашнего компьютера – это описанным в статье образом настроить связку apache+php+mysql и связать доменное имя с IP-адресом вашего домашнего компьютера.

Повторюсь:

- О том как настраивать Apache + PHP + MySQL я писал .

- О том, как связать IP-адрес и доменное имя я записал .

Так что вы вполне вооружены знаниями, остается лишь правильно их применить.

Замечательно, если компьютер подключен напрямую к провайдеру сетевым проводом и в настройках сети задан внешний статический IP-адрес. Именно этот IP и нужно будет указать в настройках доменного имени.

Но, обычное дело, когда компьютер, который будет выполнять роль сервера, расположен либо в локальной подсети, либо перед ним стоит какой-нибудь АДСЛ-модем и внешний IP-адрес (который вы можете узнать воспользовавшись сервисом myip.ru) – это адрес роутера либо адрес АДСЛ-модема. IP-адрес компьютера имеет при этом локальный вид (либо 192.168.0.ХХХ, либо 10.0.0.Х). Здесь уже сложнее, но все равно можно реализовать поставленную цель и сделать у себя дома филиал хостинг-провайдера.

Необходимо реализовать так называемый проброс портов . Т.е. настроить роутер или АДСЛ-модем следующим образом:

- Пользователь набрал адрес сайта сайт.

- Name-сервер сообщил IP-адрес. Этот IP-адрес является внешним статическим адресом либо роутера, либо АДСЛ-модема, либо шлюза, через который компьютер-сервер выходит в интернет.

- Запрос пришел к роутеру на 80-й порт (именно через 80-й порт осуществляется http-соединение).

- Роутер настроен таким образом, что все запросы, приходящие на 80-й порт, перенаправляет компьютеру локальной подсети с определенным IP, например 192.168.0.200.

- Запрос пошел на локальный компьютер-сервер, а там его уже с радостью встречает Apache и выдает нужный сайт.

Но с пробросом портов мы разберемся чуть позже. Пока поковыряем сам компьютер-сервер.

Характеристики компьютера-сервера

Здесь очень сложно говорить о каких-либо точных параметрах.

Если вы собираетесь поиграть в хостинг-провайдера, то сервер должен быть четырехъядерным компьютером с 4-мя Гигабайтами оперативки, и несколькими жесткими дисками, объединенными в RAID-массив . Такой компьютер делится на несколько виртуальных серверов, управление которыми дается клиентам.

Если вы собрались подхостить пару сайтов, типа сайт, то вполне хватит обычного современного компьютера. А там уже нужно экспериментировать для достижения оптимального результата.

Направлю ваше внимание на следующую особенность: важно количество оперативной памяти на сервере. Т.к. процесс загрузки посетителем одной и той же страницы сайта можно ускорить путем хранения данных в оперативной памяти. Чем больше оперативки, тем лучше.

Скорость чтения с жесткого диска и его надежность можно повысить все теми же RAID-массивами .

Но неоспоримым оказывается тот факт, что ОС Windows, из-за огромного количества дыр в безопасности, множества вирусов, нестабильности работы – на сервере не место.

Поэтому на серверах бал правят операционные системы семейства Linux. Но не пугайтесь, принципы работы в Linux не так и сложны, как кажется, а настройка Apache + PHP + MySQL практически ничем не отличается от настройки в Windows.

Установка ArchLinux

Давайте-ка, уважаемый читатель, я познакомлю вас с установкой операционной системы ArchLinux.

Существует множество операционных систем, разработанных на основе Linux . Это и всем известная Ubuntu и openSUSE и многие другие. Одним из завоевавших популярность дистрибутивов является ArchLinux. С ним-то мы и будем знакомиться.

Почему именно ArchLinux:

- На мой взгляд, оптимально подходящий дистрибутив для сервера. В нем нет никакой лишней тяжести, все настраивает и устанавливает сам пользователь (оставляя только то, что действительно необходимо).

- Мощная система установки обновлений Pacman .

Теперь я подробно опишу процесс установки ArchLinux на будущий сервер.

В случае обычного домашнего компьютера, из которого мы планируем сделать сервер, подойдет дистрибутив Core ISOs: i686 , Torrent-ссылку на который можно получить на этой странице .

Данный дистрибутив представляет собой 32-х битную версию с присутствующими в скачиваемом образе необходимыми файлами установки (короче говоря, это то, что нам нужно).

Как я уже писал в статье о моих программах, я буду использовать инструментарий .

Для начала запускаю из TCUP Torrent-клиент и примерно через час дистрибутив у меня на жестком диске.

Теперь, как вы, наверное, догадались, нужно нарезать дистрибутив на диск. Идеальным окажется обычный CD, но где его в наше прогрессивное время взять, поэтому я использую чистую DVD (ради такого дела не жаль).

Нарезать будем плагином все того же TCUP.

Запускаем плагин Прожиг CD/DVD . Далее выбираем пункт Проект: Образ ISO/CUE и, прямо в открывшееся содержимое пункта, копируем скачанный дистрибутив ArcLinux-а (при помощи всем знакомой кнопки F5).

Запись начинаем, естественно, кликом на пункт Запись диска .

Выбираю низкую скорость записи, спешить нам некуда. И поехали трансформировать образ диска в загрузочно-устновочный диск ArcLinux.

После завершения всех этих нехитрых операций мы имеем диск с дистрибутивом, который нужно вставить в подопытный компьютер и загрузиться с него.

Считается, что дойдя до понимания необходимости установки Linux, пользователь знает где именно в BIOS подопытного компьютера можно включить загрузку с CD.

Грузимся с CD.

Выбираем пункт Boot Arch Linux Live CD . После чего наблюдаем процесс загрузки операционной системы.

Хозяйке на заметку root – это логин суперпользователя, обладающего самыми широкими правами по настройке системы.

В установочном режиме учетная запись root-пользователя не имеет пароля. Пароль мы создадим на одном из последних шагов установки ОС Arch Linux.

Если обратить внимание на появившуюся, после авторизации, красиво оформленную надпись, то станет понятно – установку нужно начитать с ввода команды / arc/ setup и подтверждаю ввод нажатием, вы не поверите, Enter.

Все, приступаем непосредственно к установке.

Последовательно будем выполнять каждый из пунктов установочного меню.

1. Select Source

На данном этапе нам предлагается выбрать между установкой с CD или из интернета. Т.к. мы скачали полный дистрибутив, то выбираем пункт CD-ROM or OTHER SOURCE и нажимаем Enter.

2. Set clock

Select region and timezone. Здесь необходимо выбрать временной регион. Я выбираю Europe и после Kiev (т.к. территориально я нахожусь в Украине).

Set time and date Здесь без лишних пояснений выбираю UTC. В режиме manuale редактирую дату. После корректировки возвращаюсь в подменю установки даты и времени, выбрав пункт return.

Настройку времени и даты я закончил, выбираю 3-й пункт Return to Main Menu.

Теперь самая интересная и сложная часть – разбивка жесткого диска. Но мы эту науку быстро одолеем.

Выбираю пункт

3. Prepare Hard Drive(s)

Разбивать будем в ручном режиме. Поэтому в подменю выбираем пункт 2. Manually Partition Hard Drives.

Я имею диск в 18 Гбайт, о чем с радостью меня информирует программа разбивки диска.

На данном этапе хочу пояснить принципы работы с оборудованием и файловой иерархией Arch Linux:

В Linux нет дисков С:, D: и т.д., как мы привыкли видеть в Windows. Здесь вся иерархия начинается от корня, обозначаемого / Все находится внутри этого слеша и распределено по папкам.

Удивительно для пользователя Windows, но все оборудование хранится в папке /dev. Мой единственный жесткий диск обозначается как sda. Именно поэтому я вижу надпись /dev/sda: 18GiB, которая говорит о том, что на компьютере есть одно устройство, распознанное как жесткий диск размером в 18 ГигаБайт и оно, как и все устройства, засунуто в папку dev.

А теперь мы приступим непосредственно к созданию разделов на жестком диске.

Выбираю диск /dev/sda и нажимаю Enter. После этого запускается программа cfdisk, при помощи которой мы и будем делить диск на разделы. Убираем приветственное окно программы cfdisk, нажав Enter и наблюдаем интерфейс программы cfdisk.

Для чистоты эксперимента я удаляю все имеющиеся разделы, выбирая внизу пункт Delete (нижнее меню, перемещаюсь при помощи курсорной клавиши вправо).

В итоге имею кучу свободного места, которую я сейчас переразмечу на ваших глазах, уважаемый читатель.

Создадим три раздела:

- Загрузочный раздел, который будет содержать ядро системы (для него нам достаточно отвести 50 Мбайт).

- Раздел подкачки или swap. Он используется для хранения данных из оперативной памяти, когда они уже там не умещаются (512 Мбайт).

- Раздел для всего остального, корневой раздел /. Для него задействуем все что осталось.

Итак, выбираю пункт New и создаю загрузочный раздел. На следующей развилке я вбираю пункт Primary. Далее выбираю размер раздела, в моем случае достаточно 50 МегаБайт. Выбор подтверждаю пунктом Beginning.

После создания раздела указываю его тип (пункт Type) как 83 (Linux).

Первый раздел создан. Теперь я перемещаюсь на пункт, символизирующий оставшееся свободное место на диске и снова нажимаю New.

Теперь я буду создавать раздел подкачки swap.

Используем вышеописанный алгоритм. Размер данного раздела будет равен 512 Мегабайт.

В качестве типа данного раздела (Type) необходимо указать 82.

Все остальное помечаем как sda3, туда мы будем монтировать корень /.

Размеченный жесткий диск sda имеет следующий вид:

Настал этап указать один из дисков, как загрузочный. Для этого мы перемещаемся на sda1 и помечаем его пунктом Bootable.

Все, уважаемый читатель, с разметкой диска покончено. Выбираем в интерфейсе cfdisk пункт write (в нижнем меню) и сохраняем внесенные изменения.

После сохранения можно выйти (пункт Quit).

Мы снова попадаем в знакомое нам меню установки Arch, где выбираем пункт DONE.

После выбора DONE, мы окажемся в подменю работы с диском, где будет заботливо выбран пункт 3. Manually Configure block devices, filesystems and mounpoints

Нажимаем Enter и переходим к монтированию разделов жесткого диска.

Перейдя в соответствующий раздел меню мы сможем указать файловые системы и точки монтирования (что именно должно располагаться в выбранном разделе жесткого диска).

Итак, начинаем с sda1. Этот раздел загрузочный. Для него оптимальной окажется файловая система ext3, поддерживающая восстановление после сбоя.

Как и договаривались, монтируем на sda1 загрузочный раздел /boot.

Никаких дополнительных опций указывать не будем, нажимаем Enter.

Аналогично вышеописанному создаем файловую систему и точку монтирования для sda2. Файловая система – swap. Это собственно все, что нужно было указать для sda2.

Sda3 будет иметь файловую систему ext3 монтировать туда будем, как и договаривались, все остальное, т.е. /.

Вот результат:

Остается лишь выбрать done и все, что мы наворотили, применится.

Вот теперь уж с настройкой жесткого диска действительно все. Arch заботливо выбирает пятый пункт в меню установки 5 Return to Main Menu.

Продолжаем устанавливать наш замечательный Linux.

В главном меню установки выбран пункт 4. Select Packages . В нем нам нужно выбрать ничто иное как base.

После выбора base появится перечень входящих в установку пакетов. Не парим себе лишний раз мозг, жмем OK.

Попадаем на 5-й пункт меню Install Packages , которым запускается установка пакетов. Если вы видите вот это

и CD старательно шуршит, значит все нормально, ждите окончания установки.

Все, уважаемый читатель, процесс установки Arch Linux закончен, приступаем к конфигурированию. Все, что мы сейчас наконфигурируем, можно будет поправить в любой удобный момент.

6. Configure System

На следующем экране нам предложат выбрать редактор для изменения текстовых файлов конфигурации. Выбираем nano и не парим мозг.

После выбора редактора текстовых файлов мы видим список всех файлов конфигурации. Но не пугайтесь, править нужно лишь часть из них.

Основной конфигурационный файл – /etc/rc.conf

Выбираем соответствующий пункт и нажимаем Enter.

Редактор nano загружает содержимое текстового файла rc.conf, расположенного в папке файлов конфигурации etc.

Для начала мы настроим сеть. Переходим к разделу NETWORKING в файле и внимательно впиваемся взглядом в строчки

#eth0="eth0 192.168.0.2 netmask 255.255.255.0 broadcast 192.168.0.255" eth0="dhcp" INTERFACES=(eth0) gateway="default gw 192.168.0.1" ROUTES=(!gateway)Значит так, если мы настраиваем сервер, то речи о динамической раздаче IP-адресов быть не может. Поэтому мы убираем комментирующую решетку перед первой строкой и ставим ее на вторую строчку. Получается вот что:

Eth0="eth0 192.168.0.2 netmask 255.255.255.0 broadcast 192.168.0.255" #eth0="dhcp"

Теперь развлекаемся с первой строкой. Вместо 192.168.0.2 прописываем IP-адрес сервера. Мой сервак находится в локальной сети и имеет адрес 192.168.0.200 (именно его я и указываю).

netmask 255.255.255.0 Это нас устраивает. Данный формат маски говорит о том, что в подсети могут находится 254 компьютера (первые три составляющие IP-адреса у них фиксированы, а последняя изменяется от 1 до 254). Ну и ладно.

broadcast 192.168.0.255 – это IP-адрес для широковещательных пакетов. Если на данный IP будет отправлен пакет, то его получат все компьютеры подсети. Ну и хорошо, нас это устраивает.

В результате имеем следующее вместо первой строки:

Eth0="eth0 192.168.0.200 netmask 255.255.255.0 broadcast 192.168.0.255"

Крутим ниже, к строке

Gateway="default gw 192.168.0.1" ROUTES=(!gateway)

Первая строка указывает шлюз. Моя локальная сеть организована таким образом, что перед сервером расположен роутер, имеющий адрес 192.168.0.1, его я и указываю в качестве шлюза. Если в вашем случае, никакого роутера нет, то администратор сети должен сообщить вам IP-адрес шлюза, его здесь и укажете.

Во второй строке нам нужно, всего на всего, убрать восклицательный знак:

ROUTES=(gateway)

С этим файлов все. Жмем ctrl+o для записи и ctrl+x для выхода.

Следующим конфигурационным файлом, к которому мы проявим интерес, будет /etc/resolv.conf

Здесь все очень просто. В формате nameserver ip необходимо указать DNS.

Прямо под строкой #nameserver

nameserver 192.168.0.1

nameserver 8.8.8.8

Кто такой 192.168.0.1 вы, уважаемый читатель, уже знаете.

8.8.8.8 – это DNS от Google. Указываю его, в качестве альтернативного.

Следующий интересный файл – /etc/hosts.deny

По умолчанию в этом файле запрещаются все соединения. Поправить это можно закомментировав строку ALL: ALL: DENY, т.е. поставить # перед фразой решетку, вот так:

# ALL: ALL: DENY

Сохраняем файл и выходим.

Следующим шагом мы подкорректируем зеркала для обновления, содержащиеся в файле /etc/pacman.d/mirrirlist

Прокручиваем файл к разделу Russia и раскомметируем строчки с адресом yandex.ru

Сохраняем, закрываем.

Последняя операция – установка пароля для супермощного пользователя root. Задайте его, и не забудьте.

Вводя пароль знайте, что в Linux символы паролей не закрываются звездочками, они просто вообще не показываются (чтобы нельзя было подсмотреть даже количества знаков в пароле и потом как-то их подобрать).

Жмем Done в самом конце.

Изменения применяются.

Последнее, что нам нужно будет сделать – это выбрать загрузчика. Пункт 7 Install Bootloader .

Здесь все просто, не парим мозг, выбираем Grub. После его выбора мы увидим содержимое файла конфигурации загрузчика. Он нас не интересует, сразу выходим оттуда.

Теперь нам нужно выбрать, куда устанавливать загрузчик. Выбираем пункт /dev/sda

Все, уважаемый читатель, 8 Exit Install .

Поздравляю, Arch Linux стоит, вводите команду reboot и не забудьте вынуть загрузочный диск из СДРОМА. Кстати, СДРОМ не откроется, пока не начнется перезагрузка, потому что диск примонтирован, вот такие особенности Linux.

Все, Linux загрузился и приглашает начать работу с ввода логина и пароля. А вы что ожидали?

Логинимся как root (пароль от рута вы сами завали, так что вводите, если не забыли).

Поздравляю, вы залогинились как root (по крайней мере, я точно залогинился).

Теперь проверим работоспособность сетевого соединения. Я надеюсь, вы подключили компьютер к локальной сети обычным сетевым проводом.

Тогда все должно работать, пишем команду ping google. com и наблюдаем веселую картину удачных пингов.

Когда картина пинга наскучит, нажмите ctrl+c.

Если ping у вас не проходит, то убедитесь в том, что вы получали в детстве достаточно витаминов.

Наконец-то теперь мы можем установить программу для удаленного SSH доступа через Putty. Помните я об этом ?

Теперь мы узнаем как это все настраивается на стороне сервера.

Установив SSH-доступ я смогу удаленно управлять сервером и записывать видеоуроки, делать обычные скрины а не сидеть перед монитором с фотоаппаратом.

У Arch есть такая замечательная штуковина, как менеджер пакетов. Называется он pacman. Назначение pacman-а – установка необходимых программ, их обновление, обновление всех имеющихся программ, установка необходимых компонентов для вновь устанавливаемых программ. В общем, замечательная вещь. Подробнее о pacman можно читать .

А пока введем команду pacman - Syu , которая синхронизует данные о пакетах на серверах Яндекса.

После завершения синхронизации мы установим программу для SSH доступа. Называется она openssh. Установка происходит командой pacman -Sv openssh

Pacman скачает и установит программу и все недостающие компоненты. Почему-то с первого раза у меня обновился только лишь pacman, а openssh не установился. Поэтому я повторяю команду pacman -Sv openssh

На этот раз попытка увенчалась удачной установкой программы.

Вот где расположен файл запуска /etc/rc.d/sshd

Для того, чтобы запустить openssh, необходимо ввести следующую команду:

/ etc/ rc. d/ sshd start

После чего будет возможен SSH-доступ к серверу.

Для доступа к серверу мы будем использовать программу Putty. Скачать ее можно либо с официального сайта , либо с Deposit Files (*.zip, 243 КБайта).

Вводим IP-адрес сервера (в моем случае 192.168.0.200) и подключаемся по SSH.

После соединения, в окошке Putty мы видим все тоже самое, что и на мониторе сервера. Клавиатуру и монитор сервера можно отодвинуть подальше, в ближайшее время они нам не понадобятся.

Напоследок мы обновим нашу систему замечательной командой pacman – Syu

В моем случае потребовалось загрузить обновлений на 100 Мбайт, так что мужайтесь, дело это не быстрое.

Пока на этом все. До следующей встречи предлагаю вам, уважаемый читатель, потыкать в google вопросами типа «основные команды linux» много всего забавного найдете.

Бывает, что любители и ИТ-специалисты создают центры обработки данных в своих домах, размещая оборудование в импровизированных серверных комнатах, гаражах, подвалах или домашних офисах. Таких людей называют серверофилы («server huggers»). Это люди, стремящиеся быть ближе к оборудованию, которое они используют.

Домашние центры обработки данных, или, как их называют, «пещерные ДЦ», играют немаловажную роль в современной жизни и развитии ИТ-технологий. Данные ДЦ, в противовес крупномасштабным дата-центрам, являются первопроходцами в испытании серверного оборудования. Такого рода энтузиасты питают страсть к ИТ и, как правило, одни из первых начинают использовать новые серверные системы, тестируя их в экстремальных условиях.

Причины создания таких центров обработки данных разнообразные. Например: мелкий веб-хостинг, запуск своих уникальных проектов или просто страсть к электронике и ИТ. Какой бы ни была мотивация, такой проект в любом случае требует некоторых адаптаций, включая как доработку питания и сетевых соединений, так и адаптацию и обновление кабельной разводки по всему дому. Предлагаем вам несколько примеров таких проектов.

Облако в подвале

Канадский ИТ-специалист Алан Бодро (Alain Boudreault) имеет в своём арсенале оборудование корпоративного класса от таких производителей, как Dell, HP, Sun, Juniper, IBM и IBM BladeCenter. Стойки с этим оборудованием он разместил в подвале своего дома. Его веб-сайт содержит подробный обзор установки, в том числе и диаграммы всех компонентов . Дата-центр включает в себя облако Open Stack MAAS (Metal as a Service) и несколько систем хранения данных (ISCSI и Fiber Channel).«Моим первым шагом была установка электроподстанции, позволяющей обеспечить силу тока в 40 ампер при напряжении 240 вольт, т.е. способной справиться при необходимости с нагрузкой 9,6 кВт/час», - рассказывает Алан. Он преподаёт разработку приложений и использует свой ДЦ для тестирования. «Серверы редко запущены все сразу, таким образом средний расход составляет 1-2 кВт в час»,- говорит он. Стоимость электричества в Quebec составляет около 7 центов за кВт. Бодро пишет, что этот тип ДЦ является занятием не для слабонервных.

Центр обработки данных - звезда YouTube

Некоторые владельцы домашних ДЦ размещают видео про них на YouTube. Самым популярным из них является Home Center Data Project , еще один проект в Канаде, разработка которого началась в 2005 году в виде двух компьютеров в шкафу и выросла к 2013 году до более чем 60 серверов. Проект был задокументирован в серии видео, которые набрали более 500 000 просмотров на YouTube. В роликах и на веб-сайте также задокументированы обширные кабельные соединения, охлаждение и процесс усовершенствования сетевой инфраструктуры.

«Данный проект был разработан не для прибыли», - пишет разработчик Этьен Валле (Etienne Vailleux) из Hyperweb Technologies. «Данная установка была собрана в качестве хобби, но через некоторое время она быстро переросла в страсть».

В 2013 году проект мигрировал из одного дома в другой. «Часть фундамента была специально разработана для размещения серверов и кондиционеров»,- рассказал Валле. «В настоящее время проект содержит 15 серверов, емкость соединения которых составляет 60 Мбит/с ».

Удивляем своего провайдера

Иногда люди устанавливают целые хранилища данных. Например, в 2012 году ИТ-специалист, известный как houkouonchi, опубликовал видео своей стойки, которое набрало более 220 000 просмотров на YouTube.«Установка, на самом деле, производилась не в центре обработки данных. Не многие имеют полноразмерную стойку, способную хранить более 150TB данных»,- писал он. «Стойка крепится через деревянный пол в цементный фундамент дома. Полностью укомплектованная стойка использует всего 1 кВт мощности, но её пропускная способность - это совсем другое дело».

В 2013 году houkouonchi сказал, что с ним связался с Verizon, который был удивлен, увидев пользователя домашнего интернета, генерирующего более 50 терабайт трафика в месяц. Размещение сервера со столь большой генерацией трафика нарушало условия обслуживания для услуги домашнего интернета, и он вынужден был перейти на бизнес-план.

Вот тур по стойке houkouonchi, размещённый в YouTube

Стойки из IKEA

Зачем использовать стандартные стойки для центров обработки данных в Вашем доме, если Вы можете разместить оборудование в стильном столике от IKEA? В одной из домашних реализаций центра обработки данных люди, увлеченные своим хобби, адаптировали шведский приставной стол LACK для комфортного размещения серверов и сетевого оборудования, создав LACKRack. Оказалось, что пространство между ножками составляет 19 дюймов. Такой же является и ширина стандартного слота в специализированных серверных стойках. Импровизированные юниты создавались с помощью уголков, прикрученных шурупами к ножкам стола.

Отсутствие стоек стимулировало появление множества дизайнерских новинок. Франк Деннемен (Frank Dennemen), технологический евангелист PernixData, адаптировал начальную спецификацию LACKRack, чтобы создать переносную 19-дюймовую стойку.

«Мой домашний офис разработан таким образом, чтобы быть всё же офисом, а не центром обработки данных», - пишет Деннемен. «Поэтому я старался разместить 19-дюймовые серверные стойки, не разрушая эстетику домашнего офиса». Разместить такую стойку Вы можете где угодно в доме.

Как должна выглядеть правильная мини-серверная

Итак, Вы - руководитель фирмы и решили организовать серверную в офисе, или же просто энтузиаст, решивший попробовать в жизни всё и построить серверную дома, подвале или гараже. Не столь важно, для чего Вам нужна серверная, если Вы уже решили создать такое чудо, необходимо знать как она должна выглядеть. В идеале серверная должна соответствовать стандарту TIA-569. Список требований к комнате, выделенной под серверную, выглядит приблизительно так:- минимальная площадь должна составлять 12 кв.м, а высота потолка - не менее 2.44 м;

- комната не должна быть отделана легковоспламеняющимися материалами;

- в комнате должна быть как минимум одна двойная заземлённая розетка, а если строго следовать стандарту, в комнате с площадью 12 кв.м таких розеток должно быть 4;

- серверная должна размещаться вдали от сильных источников электромагнитного излучения (серверная на расстоянии 2 м от трансформаторной будки - это плохая затея);

- для освещения в комнате рекомендуется использовать галогеновые лампы, подойдут также и «экономные лампы», которые обеспечат минимальное выделение тепла, хорошее освещение и высокий срок службы;

- влажность в помещении должна быть на уровне 30-55 % при температуре от 18 до 24 градусов Цельсия.

- ширина стойки должна быть 19 дюймов (482,6 мм);

- глубина подбирается в зависимости от используемого оборудования: 60, 80 или 90 см;

- крепежные отверстия располагаются на вертикальных элементах стойки каждые 1.75 дюйма (4.4 см);

- высота стандартных стоек составляет 6,12, 20, 42 U и т.д.

Для минимизации возможных проблем с питанием стоит использовать источник бесперебойного питания. Лучше всего подойдёт ИБП мощностью 5-6 кВА, но если Ваш бюджет ограничен, или Вы не планируете использовать мощное оборудование в больших объёмах, а хотите, к примеру, всего 3 или 4 машины, Вы можете использовать и более слабый ИБП на свой страх и риск. Продавцы-консультанты могут предложить Вам ИБП с различной топологией: Line-Interactive UPS, Passive Standby (Off-Line) UPS и Double-Conversion (On-Line) UPS. Производители утверждают, что наилучшим вариантом для домашних серверов будет Line-Interactive UPS, но это не совсем так. Всё же лучший вариант - это ИБП с топологией On-Line UPS (непрерывного действия), к примеру, APC Smart-UPS RT 5000VA.

Данные советы - это основное, что Вам нужно знать для обустройства серверной и комфортной работы Вашего оборудования.

Хотелось бы добавить, что какой бы заманчивой ни была перспектива размещения серверов у себя дома, стоит помнить и понимать, что будет довольно трудно достичь приемлемого аптайма в домашних условиях. Как пример, приведу пару слов с форума .

Аптайма даже близкого к 5 минутам в год не будет по причине человеческого фактора. Вот, что было в моей практике и приводило к такому низкому аптайму:

- забыл заплатить за инет;

- сдох винт в серваке, raid"а не было;

- забился пылью - надо почистить;

- сдох вентилятор - надо менять;

- задели провод;

- сервак использовался как файлопомойка, закончилось место, потому что записали несколько фильмов;

- ядро линуха недообновилось, комп не вышел из ребута;

- провайдер резко сменил настройки dns"ов;

- мигнул свет;

- родители решили помыть полы;

- вывалился из разъема sata-кабель;

- wi-fi карта, которая раздавала инет, резко зависла и ввела комп в ступор и т.д.

Также необходимо помнить, что:

- данная затея не из дешевых;

- Вам будет трудно обеспечить оптимальные условия для работы серверов;

- в случае пожара и т.п. Вы рискуете не только данными и оборудованием, но и своей жилплощадью;

- постоянно отслеживать работу серверов возможно только в том случае, если вы постоянно находитесь в пределах быстрой досягаемости Вашей серверной;

- при длительных поездках Ваш проект будет заморожен, так как оставлять аппаратуру включенной без пересмотра - это большой риск.

10 признаков того, что Вы - серверофил

- Вы предпочитаете большие помещения с кондиционерами и минимумом мягкой мебели, а так же с люминесцентным освещением;

- постоянный гул и белый шум успокаивают Вас;

- использование цифрового отпечатка или ручной биометрики для получения доступа в комнаты все еще интересует Вас;

- Вы не можете пройти мимо грязных или дезорганизованных кабельных соединений, не выражая неодобрения и не качая головой;

- мигающий зеленый или желтый свет оказывает успокаивающее, почти гипнотическое действие, когда вы смотрите на него;

- Вам нравится чувство холода от металлических стоек, Вы часто стремитесь коснутся их;

- Вы думаете, что облако - это то же самое, что и виртуализация, нечто, на что стоит когда-нибудь обратить внимание, но пока нужно решать текущие проблемы пользователей;

- Вы полагаете, что облачные данные не безопасны, независимо от того, что поставщик говорит Вам;

- у Вас есть собственные мысли как улучшить работу оборудования посредством прямого воздействия (к примеру замены элементов);

- Вы питаете страсть к компьютерному оборудованию, всегда пытаетесь его улучшить и найти нестандартные решения для оптимальной работы.

Свой первый домашний сервер я собрал в 2008 году: Celeron E1400 на mATX платформе ASUS и всё это в прекрасном корпусе Antec NSK 1380. Корпус действительно хорош за исключением двух моментов: 1. Нестандартный формат блока питания (и как следствие возможность поставить только низкопрофильное охлаждение на процессор) 2. Малое число посадочных мест под накопители и плохое их охлаждение (поэтому я никогда не ставил туда больше одного диска - и так было тесно и жарко).

С ролью маршрутизатора эта машина справлялась прекрасно. Но организация на ней файлопомойки уже создавала неудобства: место вечно кончается -> приходится менять диск на новый большего размера (ну не чистить же его в самом деле!) -> для этого надо перенести на новый диск систему -> уж если переносишь, то не обновить ли ее заодно, а то пакеты с новыми часовыми поясами под текущую приходится искать чуть ли не собаками (пламенный привет Федоре) -> … И так каждый раз.

Захотелось собрать новый сервер, который позволил бы организовать RAID или хотя бы просто установить несколько дисков, чтобы решить проблему с местом радикально и надолго. А еще поднять несколько виртуальных машин для производственных нужд. А еще…

Но самый главный аргумент - это, конечно, желание пощупать новые железки! Поэтому я определился с требованиями и отправился в магазин гуглить.

Требования:

- бесшумность

- компактность

- возможность удобной установки/замены дисков и достаточное количество посадочных мест (от 4)

- универсальность (больше разъемов/интерфейсов, всяких и разных, мало ли что захочется прикрутить)

Форм-фактор Mini-ITX не был обязательным критерием, но логично вытекал из второго пункта. Поэтому я решил для себя, что попытаюсь выжать из него максимум и только в крайнем случае начну смотреть в сторону mATX.

Disclaimer

Выбор железа

1. Корпус

Первым делом я занялся поиском корпуса. Таковых под Mini-ITX сейчас великое множество, однако большинство предназначено для недорогих неттопов.

Подходящие для домашнего сервера/NAS варианты можно пересчитать по пальцам:

| Fractal Design Array R2 |  |

CFI-A7879 | |

|

Chenbro ES34069 |  |

Chenbro SR30169 |

и пара других.

Причем большинство из них непросто или невозможно купить в России. В итоге я выбрал Chenbro SR30169. Его главные плюсы: удобная установка четырех 3.5″ дисков (с поддержкой HotSwap), продуманное охлаждение с использованием 120мм вентиляторов, стандартный блок питания (в абсолютном большинстве прочих корпусов используются Flex ATX либо нестандартные форм-факторы), удобство монтажа.

Видео о внутреннем устройстве:

2. Материнская плата

Критерии:

современная платформа с поддержкой процессоров Ivy Bridge, 2 встроенных сетевых карты, PCI-E разъем (для установки WiFi), не меньше четырех разъемов SATA (но в идеале не меньше пяти - 4 в рейд + 1 под систему), miniPCI-E на всякий случай, достаточное количество портов USB (желательно 3.0), несколько видео-интерфейсов (я не знал, к какому именно интерфейсу придется подключаться, поэтому минимум хотелось HDMI и D-Sub)

|

Intel® Server Board S1200KP |  |

Intel® Server Board S1200KPR |

|

ZOTAC Z77ITX-A-E |  |

Jetway NF9E-Q77 |

Первые две довольно специфичны. С одной стороны, они поддерживают процессоры Xeon и память ECC, с другой стороны возможности расширения весьма ограничены: всего четыре USB (и только 2.0), всего четыре SATA, нет встроенного звука, один видеовыход, только один слот расширения. Разумеется для сервера организации эти моменты неактуальны, но для домашнего применения хочется большей гибкости. К тому же, плата с индексом KP не поддерживает 22нм процессоры, а KPR на момент сбора машины (июль-август 2012) не было в продаже.

Также не было в продаже и ZOTAC Z77ITX-A-E, хотя плата конечно очень интересная. Модуль WiFi в комплекте, две гигабитные сетевые карты - красота!

Еще несколько плат готовились на тот момент к выходу, вышли или нет не знаю, поэтому здесь про них подробно не пишу.

На днях очень вовремя вышла юзера track об отказах серверной памяти. Настоятельно рекомендую ознакомиться с ней прежде, чем использовать предложенную мной конфигурацию для критических задач.

В конечном итоге я остановился на плате Jetway NF9E-Q77. Удивительно, сколько всего компании Jetway удалось уместить в плате формата Mini-ITX! Поддержка 3го поколения процессоров Intel (LGA1155), 6 портов SATA (2xSATA3 + 4xSATA2), 2хUSB3.0 + 4xUSB2.0 (+ по паре портов каждого типа разъемами на плате), PCI-E + miniPCI-E, 2 гигабитных сетевых адаптера Intel, 3 видео-выхода (HDMI, DVI-D, D-Sub) не считая LVDS. Также есть два порта RS232, RS422/485 с разъема на плате, GPIO, Watchdog, поддержка iAMT, vPro и т.п.

Тип используемой памяти DDR3 SODIMM.

Найти эту плату в продаже в России мне не удалось, но к счастью она обнаружилась в немецком магазине minipc.de . Доставили курьерской службой. За вычетом VAT и со стоимостью доставки вышло ровно 200$. Цена за такую плату на мой взгляд более чем разумная. Кстати, плата производится по стандартам, подразумевающим в том числе промышленное применение, а значит повышенную живучесть (по информации с сайта jetway, автор статьи гарантий не дает =)).

3. Жесткие диски

Все последние лет 10-15 я пользуюсь только продукцией IBM/Hitachi. Поэтому я выбрал модель с максимальным объемом при адекватной цене (на момент сборки это была HITACHI Deskstar 7K3000 HDS723020BLA642, 2Тб) и приобрел две штуки с мыслью докупить еще две, когда определюсь с софтом (у меня были сомнения в том, что это случится быстро - так оно и вышло). Так как в выбранном корпусе в дополнение к четырем HotSwap дискам штатно могут быть установлены только 2,5” диски, я решил туда поставить диск из ноутбука, который все равно планировал заменить на SSD.

Этой зимой были докуплены два диска HITACHI Deskstar 5K3000 HDS5C3020ALA632.

4. Блок питания

БП я просто выбрал как самый маломощный (а значит дешевый) из приличных и тихих, которые были в наличии ближайшем гипермаркете.

Таковым стал AeroCool VP-450 .

Конечно, в таком компактном корпусе лучше было бы взять БП со съемными кабелями, но стоят они значительно дороже, и встречались отзывы, что в данном корпусе разъемы кабелей могу начать конфликтовать с процессорным охлаждением.

5. Процессор

От процессора мне нужно было больше ядер, меньше тепла и разумная цена. Хотя нет, еще нужен был встроенный видео-чип. Выбрал Intel Core i5 3550 .

6. Охлаждение на процессор

Здесь хотелось получить тишину, хорошее охлаждение и при этом не прогадать с габаритами. Из подходящего в ближайших магазинах оказался Arctic Cooling Alpine 11 Plus .

Ну что ж, железо закуплено, приступим к сборке!

Сборка

Автор застал еще те времена, когда маркировка разъемов/переключателей на материнской плате считалась дурным тоном, инструкции писали для трусов и поэтому в страну медведей не завозили, а развернув процессор не той стороной можно было быстро и очень дорого получить прикольный брелок на свой мобильный связку ключей. Не говоря уже об обряде окропления каждой собранной машины собственной кровью, для чего заботливые китайцы обязательно оставляли кромки кропуса острыми на случай, если сборщик забыл прихватить специальный жертвенный нож или по неопытности вовсе не знает о таковой необходимости. К сожалению, современным производителям в погоне за прибылью плевать на традиции и на заботу о досуге сборщика. Тех, кто надеялся пролить над статьей скупую слезу ностальгии, дальнейший материал лишь разочарует.

Корпус выполнен из стали SGCC толщиной 0.8мм и производит впечатление монолитности, никаких зазоров и люфтов не наблюдается, все кромки аккуратно развальцованы. Боковые стенки зафиксированы винтами с накаткой. Большую часть задней стенки занимает основание для крепления блока питания. Оставшееся место отдано под вентиляционную решетку и панель разъемов материнской платы. Имеется выдвижное ушко, позволяющее закрыть корпус на амбарный замок (правда только с одной стороны, что в данном случае имеет мало пользы) или посадить его на привязь. Есть разъем для замка Kensington.

Внутри пространство корпуса разделено на две части: задняя половина предназначена для материнской платы и блока питания, переднюю же практически целиком занимает корзина жестких дисков и ее охлаждение.

Корзина поддерживает железные RAID-контроллеры и рассчитана на 4 3,5”/2,5” SATA/SAS диска с возможностью горячей замены. Для удобства таковой установка дисков производится с фронтальной стороны корпуса.

Каждый диск закрепляется винтами в лотке, который затем вставляется в корзину. Во включенном состоянии каждый лоток светится синим светом. Может показаться, что на них имеются светодиоды, однако решение гораздо изящней - индикация расположена на задней стенке корзины, а на переднюю панель выведена с помощью оптических волноводов!

Для ограничения доступа к фронтальной панели корпуса имеется хлипкая пластиковая дверца с замком. На мой взгляд она могла бы быть и металлической, но этот нюанс я готов производителю простить =)

Материнская плата вызвала у меня подлинное восхищение! К сожалению, фотографии не позволяют передать ощущение качественно сделанного продукта, которое чувствуешь, когда держишь эту плату в руках. Как производитель смог столько всего уместить в этой крохе, при этом не забыв соблюсти все стандарты на расположение компонентов? Дабы не повторяться я не буду перечислять заново все ее возможности, желающие могут обратиться к первой части статьи или к спецификации на сайте Jetway.

Несмотря на то, что в охлаждении процессора мне пришлось отказаться от любимого формата 120мм и согласиться на компромиссные 92, у меня оставались сомнения, что достаточно габаритный кулер встанет без приключений.

AC Alpine 11 Plus устанавливается на пластиковые планки, предварительно закрепленные на плате. И хотя эти планки встали впритык к окружающим компонентам, единственное, что мне пришлось дополнительно сделать - это снять пластиковый фиксатор с разъема PCI-E x16 и слегка отогнуть хвост разъема.

Для установки блока питания необходимо снять специальную корзину в верхней части корпуса. Затем она крепится к БП, маленький удлинитель подключается в разъем питания, после чего конструкция в сборе устанавливается обратно в корпус. Таким образом производитель избавляет нас от провода питания, торчащего из верхней крышки корпуса.

У БП в наличии целый ворох разъемов, половина которых нам не понадобится.

Все, что мы можем сделать - это по доброй русской традиции убрать их на антресоли. Для разводки кабелей из закромов был извлечен фиксатор на двустороннем скотче.

Теперь можно установить материнскую плату. Охлаждение процессора вошло под БП с солидным запасом в несколько миллиметров. На время установки платы пришлось снять воздуховод дисковой корзины, но делается это элементарно.

На фото с установленным обратно воздуховодом видно, что ребра радиатора процессора оказались расположены аккурат поперек направления движения воздуха из корзины. И для верности отделены от воздуховода модулями памяти. К сожалению, данная модель процессорного охлаждения не позволяет развернуть его на 90 градусов.

Других нюансов во время сборки машины обнаружено не было. В частности, когда позже я решил добавить еще одну планку памяти, я легко смог это сделать без каких-либо проблем. Таким образом, единственный критичный момент в процессе сборки - высота охлаждения процессора и разводка кабелей БП.

Эффективность охлаждения и шум

На данный момент у меня в корзине стоят четыре 2TB диска Hitachi, их температура не превышает 37 градусов (в простое 34). Температура 2,5” системного диска обычно 31-33 градуса. Процессор в простое - 40 градусов.

Шум от системы главным образом состоит из шуршания воздуха. Но для этого пришлось поставить регулятор оборотов на вентилятор корзины. На штатных оборотах тихим его никак не назовешь (хотя производитель в рекламном буклете утверждает обратное). В перспективе планирую его заменить на что-то более бесшумное.

Заключение

Когда я собирал сервер, я еще не знал, какой софт на него поставить и планировал в том числе поднять статьей обсуждение этого вопроса. Несмотря на то, что в итоге (да простят меня почитатели *nix) я остановился на Windows Server 2012, для многих этот вопрос остается открытым, комментарии на эту тему приветствуются.

P.S. Цена системы без жестких дисков получилась в районе 22 килорублей.

UPD: хочу обратить внимание на то, что мне нужно нечто большее чем просто NAS. Эта же машина должна быть и тестовой средой, и средой разработки. Естественно лучше было бы развести эти роли на разные машины, но моя квартира не настолько большая. Именно поэтому выбрано железо, избыточное для обычного NAS и именно поэтому устройства типа Synology не подходят.

Практически в любой локальной компьютерной сети оказывается востребован файл-сервер . Хранилище данных необходимо и в "самопальной" сети - масштаба дома, деревни, школы, дачного посёлка. Это просто удобно, когда есть отдельное хранилище для "тяжелого" контента - HD-видеофильмов, музыки, ПО и т.д. Но фирменный файл-сервер - удовольствие не из дешевых. Изрядно сэкономить можно, превратив старый ПК в домашний файл-сервер. Для этого потребуется лишь установить специальный софт и настроить его.

Фактически, мы сделаем своими руками NAS (Network Attached Storage) - сетевую систему хранения данных, сетевое хранилище . То есть, компьютер с некоторым дисковым массивом, подключенный к локальной сети и поддерживающий работу по принятым в ней протоколам.

В нашем примере для организации NAS мы используем дистрибутив FreeNAS . FreeNAS - это свободная операционная система для сетевого хранилища . FreeNAS основан на FreeBSD с использованием Samba и PHP, поддерживает software RAID. К нему можно получить доступ по протоколам CIFS (SMB), Apple Mac AFP, FTP, SSH, iSCSI и NFS. Для работы FreeNAS необходим компьютер с процессором i386 или x86-64, с минимум 128 Mб оперативной памяти и 500 Mб дискового пространства. Также требуется возможность загрузки с привода оптических дисков.

Мы рассмотрим установку и настройку 7-й ветки FreeNAS. Поскольку FreeNAS базируется на FreeBSD, список поддерживаемого оборудования для них совпадает. Как показывает практика, для нормальной работы системы требуется хотя бы 512 Мб RAM. Для домашнего NAS 1-2 Гб памяти будет более чем достаточно.

Главный компонент домашнего NAS - жёсткие диски . Понятно, что при возможности стоит выбирать ёмкие HDD с большим буфером и частотой вращения 5400-5900 RPM - они не будут сильно шуметь и нагреваться при работе. Но преимущество описываемой системы как раз в том, что её можно собрать из кучи разнообразных старых винчестеров, объединив их в дисковый массив . При этом для SATA-дисков стоит выставить в BIOS режим совместимости с IDE.

FreeNAS не требует мощной системы - хватит и старого Pentium или Athlon. Если NAS-система собирается "с нуля", достаточно будет платы с чипом Intel Atom и пассивным охлаждением - такая платформа будет тихой, негреющейся и энергоэкономичной. Видеопамять также имеет смысл снизить до минимума. На время установки нам также понадобится CD-привод - потом его можно будет отключить.

Собрав систему, устанавливаем FreeNAS. Качаем ISO-образ системы, пишем его на CD, указываем в BIOS загрузку с оптического привода и перегружаемся. Загрузчик предлагает несколько вариантов запуска системы. Загружаясь в режиме по умолчанию, FreeNAS выводит основное меню.

Выбираем полный (Full) вариант установки и указываем диск, на который будем инсталлировать ОС. Для раздела с ОС желательно выделить примерно 500 Мб дискового пространства. Установка занимает всего пару минут, после чего нужно перезагрузиться . Оптический привод уже можно отключить.

Первым делом следует изменить настройки сетевого интерфейса. Выбираем в меню пункт номер два - в случае, если локальная сеть имеет адресацию, отличную от 192.168.1.0/24. Лучше всего для файл-сервера задать статический IP-адрес - не забудьте только указать адрес основного шлюза и DNS-сервера.

После того, как эти настройки будут применены, монитор и клавиатуру также можно отключить. Далее вся настройка пойдёт только через веб-интерфейс по адресу http://ip-адрес-NAS/ (его мы задали ранее). По умолчанию логин - admin, пароль - freenas.

Войдя под ними, отправляемся в раздел System > General Setup. Там меняем язык интерфейса , выставляем часы, и при необходимости - включаем синхронизацию с NTP-сервером. Сохраняемся и обновляем управляющую страницу. Не забываем поменять пароль для входа в веб-интерфейс, снова сохраняемся, выходим и логинимся заново.

Теперь нужно подключить swap-раздел. Отправляемся в секцию "Диагностика" > "Информация" > "Разделы" и смотрим там информацию о разбивке диска. Наш диск разбит на три раздела разного объёма - для ОС, данных и подкачки. Определяем путь до раздела подкачки. Имя диска в нашем примере - /dev/ad0 (оно видно сверху), по размеру (256 Мб) понятно, что для swap используется третий раздел. Путь к нему будет выглядеть как /dev/ad0s3. Во время установки нам этот путь был показан сразу после форматирования диска . Переходим по пути "Система" > "Дополнительно" > "Файл подкачки ", выбираем тип устройства и указываем путь. Сохраняемся.

Теперь следует добавить в систему диски. Проходим путем "Диски" > "Управление" и кликаем на список. Выбираем в списке требуемый диск. Включаем поддержку SMART. Если используется только один диск (на который и установлена ОС), выбираем UFS with Soft Updates. При добавлении другого, уже отформатированного диска с данными, следует указать соответствующий тип файловой системы . Нажимаем "Добавить".

Если система собрана с использованием ещё не отформатированных дисков, то переходим в раздел "Диски" > "Форматирование", выбираем нужный диск и форматируем его. Специалисты рекомендуют использовать UFS, хотя это и не обязательно.

Далее монтируем все использованные нами HDD. Для этого проходим путем "Диски" > "Точка монтирования", нажимаем плюсик, выбираем в качестве типа "диск", потом собственно накопитель, указываем номер раздела и тип файловой системы, а также вводим имя точки монтирования. Замечу, что для каждого диска они должно быть уникальным. Нажимаем кнопки "Добавить" и "Применить изменения". Базовая установка FreeNAS завершена.

Теперь откроем доступ к NAS по сети. Для этого потребуется включить службу CIFS/SMB (NetBIOS). В настройках меняем имя рабочей группы, имя NAS в сети, выставляем кодировки, включаем сервер времени и разрешаем AIO. Прочие параметры оставляем по умолчанию, после чего жмем "Сохранить и перезапустить". Далее следует добавить как минимум один сетевой ресурс: указываем имя и комментарий, а также путь до него.

Изначально все точки монтирования находятся в каталоге /mnt. Соответственно, путь до корня накопителя выглядит так: /mnt/точка_монтирования/ (в нашем случае - /mnt/data/). При настройке рекомендуется создать в корне диска несколько папок и уже их добавлять в сетевые ресурсы. Если NAS содержит несколько дисков, всех их следует "расшарить" аналогичным образом.

Теперь в сетевом окружении Windows виден созданный файл-сервер с полным доступом. Чтобы управлять файлами и папками прямиком из веб-интерфейса, применяем файл-менеджер из раздела "Дополнительно". Логин и пароль для него аналогичны таковым у пользователей FreeNAS.

SMB-ресурсы используются в локальной сети; для внешнего доступа следует включить FTP-сервер . Соответственно, на роутере нужно открыть 21-й TCP-порт, а также включить DDNS-службу (присутствует в составе FreeNAS). В параметрах службы FTP разрешаем вход только авторизованных пользователей. Сохраняем настройки.

Управление пользователями - через раздел "Доступ" > "Пользователи". Для доступа пользователя к FTP-серверу указываем в качестве основной группы ftp.

В случае с NAS для домовой сети (как в нашем случае) также стоит включить встроенный во FreeNAS Bittorrent-клиент Transmission. В его настройках указываем папку, куда будут складываться закачиваемые файлы. Затем выбираем каталог для отслеживания torrent-файлов - как только в него будет закинут torrent, Transmission автоматически добавит закачку. Ссылка на веб-интерфейс Bittorrent-клиента по умолчанию выглядит как http://ip-адрес-NAS:9091/.

Ну и в последнюю очередь настраиваем UPnP-медиасервер. Тут достаточно указать папки с медиафайлами и выбрать каталог, в котором поместится база данных этого сервиса. Также указываем подходящий профиль для совместимости с сетевыми медиаплеерами. Если нужны дополнительные настройки - кликайте по ссылке внизу страницы с параметрами.

Когда всё настроено, Windows легко определяет NAS как сетевое медиаустройство и позволяет напрямую слушать с него музыку, просматривать видео и картинки .

Вся эта процедура не единожды была описана в разных источниках в Рунете. На практике мы её применили, когда делали коллективный файл-сервер для своей домовой сети - в моём доме она объединяет более полусотни ПК. NAS мы собрали, "нашпиговав" старый десктоп винчестерами - по большей части также не новыми. Однако всё работает вполне нормально. Собранный файл-сервер мы установили в одной из квартир - там же, где стоит ADSL-модем , обслуживающий домовую сеть.

Виктор ДЕМИДОВ