Парсинг (Parsing) – это принятое в информатике определение синтаксического анализа. Для этого создается математическая модель сравнения лексем с формальной грамматикой, описанная одним из языков программирования. Например, PHP, Perl, Ruby, Python.

Когда человек читает, то, с точки зрения науки филологии, он совершает синтаксический анализ, сравнивая увиденные на бумаге слова (лексемы) с теми, что есть в его словарном запасе (формальной грамматикой).

Программа (скрипт), дающая возможность компьютеру «читать» – сравнивать предложенные слова с имеющимися во Всемирной сети, называется парсером. Сфера применения таких программ очень широка, но все они работают практически по одному алгоритму.

Как работает парсинг, что это такое? Алгоритм работы парсера.

Независимо от того на каком формальном языке программирования написан парсер, алгоритм его действия остается одинаковым:

- выход в интернет, получение доступа к коду веб-ресурса и его скачивание;

- чтение, извлечение и обработка данных;

- представление извлеченных данных в удобоваримом виде – файлы.txt, .sql, .xml, .html и других форматах.

В интернете часто встречаются выражения, из которых следует, будто парсер (поисковый робот, бот) путешествует по Всемирной сети. Но зачастую эта программа никогда не покидает компьютера, на котором она инсталлирована.

Этим парсер коренным образом отличается от компьютерного вируса – автономной программы, способной к размножению, хотя по сути своей работы он похож на трояна. Ведь он получает данные, иногда конфиденциального характера, не спрашивая желания их владельца.

Виртуальный хостинг сайтов для популярных CMS:

Зачем нужен парсинг?

Сбор информации в интернете – трудоемкая, рутинная, отнимающая много времени работа. Парсеры, способные в течение суток перебрать большую часть веб-ресурсов в поисках нужной информации, автоматизируют ее.

Наиболее активно «парсят» всемирную сеть роботы поисковых систем. Но информация собирается парсерами и в частных интересах. На ее основе, например, можно написать диссертацию. Парсинг используют программы автоматической проверки уникальности текстовой информации, быстро сравнивая содержимое сотен веб-страниц с предложенным текстом.

Без программ парсинга владельцам интернет-магазинов, которым требуются сотни однотипных описаний товаров, технических характеристик и другого контента, не являющегося интеллектуальной собственностью, было бы трудно вручную заполнять характеристики товаров.

Возможностью «спарсить» чужой контент для наполнения своего сайта пользуются многие веб-мастера и администраторы сайтов. Это оправдано, если требуется часто изменять контент для представления текущих новостей или другой, быстро меняющейся информации.

Парсинг – «палочка-выручалочка» для организаторов спам-рассылок по электронной почте или каналам мобильной связи. Для этого им надо запустить «бота» путешествовать по социальным сетям и собирать «телефоны, адреса, явки».

Ну и хозяева некоторых, особенно недавно организованных веб-ресурсов, любят наполнить свой сайт чужим контентом. Правда, они рискуют, поскольку поисковые системы быстро находят и банят любителей копипаста.

Основа работы парсера.

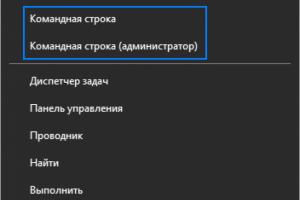

Конечно же, парсеры не читают текста, они всего лишь сравнивают предложенный набор слов с тем, что обнаружили в интернете и действуют по заданной программе. То, как поисковый робот должен поступить с найденным контентом, написано в командной строке, содержащей набор букв, слов, выражений и знаков программного синтаксиса. Такая командная строка называется «регулярное выражение». Русские программисты используют жаргонные слова «маска» и «шаблон».

Чтобы парсер понимал регулярные выражения, он должен быть написан на языке, поддерживающем их в работе со строками. Такая возможность есть в РНР, Perl. Регулярные выражения описываются синтаксисом Unix, который хотя и считается устаревшим, но широко применяется благодаря свойству обратной совместимости.

Синтаксис Unix позволяет регулировать активность парсинга, делая его «ленивым», «жадным» и даже «сверхжадным». От этого параметра зависит длина строки, которую парсер копирует с веб-ресурса. Сверхжадный парсинг получает весь контент страницы, её HTML-код и внешнюю таблицу CSS.

Парсеры и PHP.

Этот серверный язык удобен для создания парсеров:

- У него есть встроенная библиотека libcurl, с помощью которой скрипт подключается к любым типам серверов, в том числе работающих по протоколам https (зашифрованное соединение), ftp, telnet.

- PHP поддерживает регулярные выражения, с помощью которых парсер обрабатывает данные.

- У него есть библиотека DOM для работы с XML – расширяемым языком разметки текста, на котором обычно представляются результаты работы парсера.

- Он отлично ладит с HTML, поскольку создавался для его автоматической генерации.

Этические и технические сложности парсинга.

Вопрос о том, является ли парсинг воровством контента, активно обсуждается во Всемирной сети. Большинство оппонентов считают, что заимствование части контента, не являющегося интеллектуальной собственностью, например, технических описаний, допустимо. Ссылка на первоисточник контента рассматривается как способ частичной легитимации. В то же время, наглое копирование, включая грамматические ошибки, осуждается интернет-сообществом, а поисковыми системами рассматривается как повод для блокировки ресурса.

Кроме этических проблем парсер способен создать и технические. Он автомат, робот, но его вход на сайт фиксируется, а входящий и исходящий трафики учитываются. Количество подключений к веб-ресурсу в секунду устанавливает создатель программы. Делать этот параметр очень большим нельзя, поскольку сервер может не переварить потока входящего трафика. При частоте 200–250 подключений в секунду работа парсера рассматривается как аналогичная DOS-атаке. Интернет-ресурс, к которому проявлено такое внимание, блокируется до выяснения обстоятельств.

Парсер можно написать самому или заказать на бирже фриланса, если вам требуются конкретные условия для поиска и чтения информации. Или купить эту программу в готовом виде с усредненным функционалом на специализированном веб-ресурсе.

Все сталкивались с ситуацией, когда нужно собрать и систематизировать большое количество информации. Для стандартных задач по SEO-оптимизации сайта есть готовые сервисы , например, Netpeak Checker — для сравнения показателей конкурирующих сайтов или Netpeak Spider — для парсинга внутренней информации по сайту. Но что, если задача нетривиальна и готовых решений нет? Есть два пути: делать все руками и долго, или загнать рутинный процесс в матрицу, автоматизировать его и получать результат в разы быстрее. О таком кейсе и пойдет речь.

Что такое парсинг сайтов и зачем он нужен

Kimono — мощный и быстрый в настройке скрейпер с интуитивно понятным интерфейсом. Позволяет парсить данные с других сайтов и позже обновлять их. Бесплатный.

Познакомиться поближе и получить краткий мануал об использовании можно (на русском) или на moz.com (на английском). Давайте попробуем спарсить что-нибудь хорошее с помощью Kimono. Например, дополним созданную нами таблицу с городами списком курортов в стране Города 2. Как это можно реализовать при помощи Kimono Labs. Нам понадобятся:

- приложение для Google Chrome — Kimono;

- таблица Google Docs.

1. Находим сайт с необходимой нам информацией — то есть перечнем стран и их курортов. Открываем страницу, откуда необходимо получить данные.

2. Кликаем на иконку Kimono в правом верхнем углу Chrome.

3. Выделяем те части страницы, данные из которых нам необходимо спарсить. Если нужно выделить новый тип данных на той же странице, кликаем на «+» справа от «property 1 » — так указываем Kimono, что эти данные нужно разместить в новом столбце.

4. Кликнув на фигурные скобки <> и выбрав «CSV », можно увидеть, как выбранные данные будут располагаться в таблице.

5. Когда все данные отмечены:

- кликаем «Done » (в правом верхнем углу);

- логинимся в Kimono, чтобы привязать API к своему аккаунту;

- вводим название будущего АРI;

- кликаем «Create API ».

6. Когда API создано, переходим в таблицу Google, куда хотим загрузить выбранные данные. Выбираем «Connect to Kimono » и кликаем на название нашего API — «Resorts ». Список стран и ссылок на страницы с курортными городами выгружается на отдельный лист.

7. Переходим снова на сайт, берем для примера Ирландию, и снова выбираем через Kimono города, которые необходимо спарсить. Создаем API, называем его «Resorts in countries

».

9. В «Crawl Strategy

» выбираем «URLs from source API

». Появляется поле с выпадающим списком всех API. Выбираем созданное нами ранее API «Resorts

» и из него автоматически загружается список URL для парсинга. Кликаем синюю кнопку «Start Crawl

» (начать обход) и следим за статусом парсинга. Kimono обходит страницы, парсит данные по заданному ранее шаблону и добавляет их в таблицу — то есть делает все то же самое, что и для Ирландии, но уже для всех других стран, что ввели автоматически и без нашего участия.

10. Когда таблица сформирована, синхронизируем Kimono Labs с таблицей Google — точно так же, как делали это в шестом пункте. В результате, в таблице появляется второй лист с данными.

Предположим, хотим, чтобы в таблице отображались все курортные города в стране города прибытия. Данные на листах Kimono обрабатываем с помощью формул для таблиц Google, и выводим в строку список городов, где еще можно отдохнуть в Австралии, кроме Сиднея.

Например, это можно сделать так . Разметить массив данных (список городов), используя логические функции и возвращая значение ячейке, равное TRUE или FALSE. На примере ниже выделили для себя города, которые находятся именно в Австралии:

- TRUE = город находится в Австралии;

- FALSE = город находится в другой стране.

По меткам TRUE определяем начало и конец обрабатываемого диапазона, и выводим в строку соответствующие этому диапазону города.

По аналогии можем вывести курортные города и для других стран.

Мы специально привели здесь достаточно простой и пошаговый пример — формулу можно усложнить, например, сделать так, чтобы достаточно было ввести страну в колонку С, а все остальные вычисления и вывод городов в строку происходили автоматически.

Результаты автоматизации

Как говорилось вначале, нам регулярно нужно составлять по 20 однотипных таблиц. Это рутинный процесс, съедающий по 40-50 минут на одну таблицу, и по 16 часов времени на каждые 20 шт. Согласитесь, 2 рабочих дня на одинаковые таблички — необоснованная трата времени. После автоматизации на одну таблицу уходит 5-10 минут, а на 20 — около 2 часов. Таблица имеет 17 ячеек, парсинг производится из 5 источников. Заполнение таблицы происходит автоматически при заполнении всего 2 ячеек с исходными данными.

Настройка и автоматизация парсинга суммарно заняла 30 часов времени, то есть потраченное время «окупится» уже на этапе генерации второй 20-ки таблиц.

Мы выпустили новую книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Парсинг - это сопоставление строки естественного языка или языка программирования с формальными правилами.

Парсинг - это инструмент работы со строковыми данными. Приведем пример, чтобы было понятно.

Представьте себя радистом на войне. Вы получаете зашифрованное сообщение. У вас есть правила дешифровки. Вы начинаете разгадывать послание согласно этому методу.

Вы смотрите вначале на символ из полученного сообщения. Потом на свою таблицу с его значением. Например, цифре “1” соответствует буква “Я”. Вы сопоставляете все символы и получаете то сообщение, которое можно прочитать.

Парсинг работает точно так же. Есть некоторый шаблон сообщения, написанный на формальном языке. С ним сравнивается какая-то строка.

Парсинг применяется в программировании, в аналитике. Может быть полезен в любой области, где есть возможность работы со строковыми данными.

Парсинг сайта - что это

В общем случае, парсинг строит шаблон последовательности символов. Например, может использоваться древовидная структура. Она показывает, в какой последовательности в строке встречаются символы. Может указывать на приоритет, если речь идет о математическом выражении.

Такие структуры нужны для анализа данных.

Парсить можно и интернет-ресурсы. Это делают, когда нужно понять, какой контент содержится на странице.

Найти на страницах сайта только ту информацию, которая нужна вам для анализа - это задача парсинга.

Скрипт парсинга работает с текстовой информацией. Он вытягивает нужные данные, представляет их в удобном виде.

Например, вы - владелец интернет-магазина. И вы хотите быстро собрать данные о других магазинах - ваших конкурентах. Вас интересует информация с карточек товаров. Вы хотите понять, как их заполняют конкуренты, что они делают лучше вас. Вы определяете, информация с каких сайтов вам нужна. Выбираете программу или скрипт, которыми будете парсить текст. Запускаете. Программа в одном файле может собрать информацию.

Например, название, цену на товар, категорию и описание. Далее вы уже сможете проанализировать это. Например, решить, какую цену установить для своего ассортимента.

А может, вам нужно поработать с отзывами клиентов? Это тоже задачка для парсинга сайта - собираете нужную информацию в одном месте и читаете, что о вашем конкуренте пишут клиенты.

Этапы парсинга данных

- Сбор контента.

Обычно в программу для парсинга загружается код страницы сайта. И с ним уже работает специальный скрипт - разбивает весь код на лексемы, анализирует, какая информация нужна пользователю. - Извлечение информации.

Пользователю не нужна вся информация со страницы. Вернемся к примеру выше. Нас интересуют только отзывы клиентов под конкретными товарами - например, кормом для кошек. будет находить в коде страницы то место, где указана категория товара: “Корм для кошек”. Далее он определит то место на странице, где размещены комментарии. И извлечет в конечный файл только тексты комментариев. - Сохранение результатов.

Когда вся нужная информация извлечена с сайтов, нужно ее сохранить. Обычно такие данные оформляют в виде таблиц, чтобы было наглядное представление. Можно вносить записи в базу данных. Как будет удобнее аналитику. - Защита сайта от парсинга

Любой владелец сайта хочет защитить свой контент. Кража любой информации - плохо. Ваш контент может появиться на другом ресурсе, ваша статья может перестать считаться уникальной.

Мы расскажем о нескольких методах, как можно предотвратить кражу контента с вашего ресурса. - Разграничение прав доступа.

Это самый простой метод. Вы можете скрыть информацию о структуре сайта. Сделать так, чтобы она была доступна только администраторам. - Установка временной задержки между запросами.

Этот метод хорошо работает, когда на сервер направляются хаотические интенсивные запросы. Они идут от одной машины с разными промежутками. Вы можете установить временную задержку между запросами, поступающими от одной машины. - Создание черного и белого списка.

Это списки пользователей. В белом находятся добропорядочные пользователи. Черный список для тех людей, которые нарушили правила поведения сайта, пытались украсть контент и т. д. - Установка периода обновления страниц.

Чтобы снизить эффективность парсинга, установите время обновления страниц в файле sitemap.xml. Вы можете ограничить частоту запросов, объем загружаемых данных. - Использование методов защиты от роботов.

Сюда относится , подтверждение регистрации на ресурсе. То, что сможет выполнить человек, но не сможет проделать машина.

Парсинг может использоваться как во благо, так и во вред. Этот метод помогает проанализировать большие объемы текстовой информации. Но в то же время, проанализировать могут вас, украсть контент, вытащить конфиденциальную информацию, которая не должна попасть в чужие руки.

Привет, ребят. Опережая события, хочу предупредить, что для того, чтобы парсить сайты необходимо владеть хотя бы php. У меня есть интересная статья о том, . И все же, что такое парсинг?

Начнем с определения. В этой статье речь пойдет о парсинге сайтов. Попробую объяснить как можно проще и доходчивее.

Парсинг, что это значит: слово понятное дело пришло от английского parse -по факту это означает разбор содержимого страницы на отдельные составляющие. Этот процесс происходит автоматически благодаря специальным программам (парсеров).

В пример парсера можно привести поисковые системы. Их роботы буквально считывают информацию с сайтов, хранят данные об их содержимом в своих базах и когда вы вбиваете поисковой запрос они выдают самые подходящие и актуальные сайты.

Кстати говоря, если вы планируете сделать мощное приложение, которое могло бы работать удаленно, то вам может понадобиться аренда dedicated сервера . Это отличный способ получить достаточно мощные ресурсы и нужное количество памяти.

Парсинг? Зачем он нужен?

Представьте себе, что вы , не , а крупный портал с множеством страниц. У Вас есть красивый дизайн, панель управления и возможно даже разделы, которые вы хотите видеть, но где взять информацию для наполнения сайта?

В интернете – где ж еще. Однако не все так просто.

Приведу в пример лишь 2 проблемы при наполнении сайта контентом:

- Серьезный объём информации. Если Вы хотите обойти конкурентов, хотите чтобы Ваш ресурс был популярен и успешен, Вам просто необходимо публиковать огромное количество информации на своем ресурсе. Сегодняшняя тенденция показывает, что контента нужно больше чем возможно заполнить вручную .

- Постоянные обновления. Информацию которая все время меняется и которой как мы уже сказали большие объемы, невозможно обновлять вовремя и обслуживать. Некоторые типы информации меняются ежеминутно и обновлять её руками невозможно и не имеет смысла.

Это самое оптимальное решение, чтобы автоматизировать процесс изменения и сбора контента.

Чем парсинг круче работы человека:

- быстро изучит тысячи сайтов;

- аккуратно отделит нужную информацию от программного кода;

- безошибочно выберет самые сливки и выкинет ненужное;

- эффективно сохранит конечный результат в нужном виде.

Как парсить сайты?

Тут я буду краток, скажу лишь, что для этого можно использовать практически любой язык программированию, который мы используем при разработке сайтов. Это и php, и C++, и python и т.д.

Поскольку наиболее распространенным среди веб-разработчиков является php, я собираюсь написать подробную инструкцию, как можно можно парсить сайты при помощи php или специальных сервисов.

Что такое парсер сайта

Парсер – это скрипт, который вытягивает нужную информацию со сторонних ресурсов.

Парсером может быть как онлайн сервис, так и программное обеспечение, которое устанавливается на компьютер.

Например, я пользовался такой программой, когда нужно было быстро наполнить интернет магазин в 10 000 товаров. Вручную я бы занимался этим целый год наверное. А так справился за неделю.

При установке такого ПО скорость работы во многом зависит от производительности вашего компа. Чем мощнее, тем быстрее происходит процесс обработки данных.

В другом случае, я воспользовался онлайн сервисом, который автоматически брал новости с одного сайта(когда они появлялись) и вставлял их на сайт клиента. Хотя на SEO продвижение такой подход влияет отрицательно. Но, как говорится, желание клиента закон.

Заказать парсинг для сайта/интернет-магазина

Если вам срочно понадобилось настроить парсинг статей на сайт или спарсить товары в магазин, можете оставить заявку и мои программисты за отдельную плату помогут решить эту задачу

Как сделать сайт дёшево и тут же найти клиентов? Ответ очевиден - использовать современные достижения техники и оптимизации. Грамотные сайтостроители уже давно применяют парсинг для удешевления конечной стоимости сайта. И быстрого его наполнения. Беспрецедентно быстрого.

Иногда владельцев сайтов смущает, насколько законна данная услуга, можно ли свободно изымать и перерабатывать материал с других ресурсов? Мы ответим на все основные вопросы, прибегнув к анализу норм действующего у законодательства, и разберёмся, что делать можно, а что есть явное нарушение закона.

Самый распространённый вопрос, который задают клиенты парсинг-компаний: «Могу ли я копировать тексты и картинки с других сайтов, чтобы в последующем перенести на свой?». Обратимся к нормам части 4 Гражданского Кодекса Российской Федерации (далее - ГК РФ), который как раз и регулирует авторские и смежные права.

Любой владелец сайта, публикующий на нём контент, приобретает права на данный контент либо путём самостоятельного создания, либо путём покупки его у писателей, фотографов, владельцев других сайтов и т.д. Тексты, картинки, карточки товаров (в полном виде), структуры сайтов выступают объектом авторского права. К слову, в России срок действия авторского права составляет 70 лет либо период от создания до смерти автора, если автор живёт более 70 лет после создания произведения (ст.1281 ГКРФ ). Поэтому Вы свободно можете парсить картины великих художников прошлого, научные трактаты, учебники, художественные произведения и т.д. соответствующих годов издания. Вообще не являются объектом авторского и права и могут быть размещены на любом ресурсе : официальные документы государственных органов и органов местного самоуправления муниципальных образований, в том числе законы, другие нормативные акты, судебные решения, иные материалы законодательного, административного и судебного характера, официальные документы международных организаций, а также их официальные переводы; государственные символы и знаки (флаги, гербы, ордена, денежные знаки и тому подобное), а также символы и знаки муниципальных образований; произведения народного творчества (фольклор), не имеющие конкретных авторов; сообщения о событиях и фактах, имеющие исключительно информационный характер (сообщения о новостях дня, программы телепередач, расписания движения транспортных средств и тому подобное) (ст. 1259 ГК РФ ) .

И ещё один приятный момент - копировать на сайт можно любую информацию, если автор сам разместил её в открытом доступе, а Вы не планируете извлекать из её использования прибыль.

Парсинг текстов

Свободно осуществляется при синонимизации. Нужно учитывать, что в русском языке для большинства слов есть не один синоним. Поэтому восстановить начальный текст не всегда представляется возможным. Понятие произведения согласно ГКРФ включает в себя не только слова, но и их определённую структуру. Грамотный владелец сайта всегда понимает, что заимствовать на 100% глупо, хотя бы структура должна быть оригинальной (в крайнем случае - изменена). О произведениях, которые копировать можно свободно, уже сказано выше. Естественно, при заказе парсинга владелец сайта понимает, что ответственность за контент, содержащийся на его ресурсе, несёт только он, а не та фирма, что предоставляет услугу парсинга. Это вытекает из положений Закона «О средствах массовой информации» .

Парсинг картинок

Пожалуй, самый сложный вопрос. Для того, кто не знаком с законом и рынком. На самом деле, всё просто. Копировать картинки с сайта компании, товары которого вы продаёте, лучше всего. Владельцу сайта фирмы-производителя выгодно расширение продаж, на практике нет ни одного судебного решения по данному вопросу, так как нет исков. Если же копируются картинки с сайтов-конкурентов, то всегда можно внести на них личностный элемент, например, логотип вашей компании. Или произвести нехитрые манипуляции с фотошопом. И тогда речь идёт о переосмыслении либо пеработке произведения, что вполне законно. Есть ещё один момент, важный в парсинге товаров. Как правило при копировании картинок, речь идёт о товарах массового производства, которые не отличаются индивидуальными чертами и на фото неотличимы от аналогичных товаров с сайта-конкурента. Доказать, что у вас был такой же фон во время фотосессии, несложно. Доказать обратное практически невозможно. И повторимся - собирать базу данных картинок можно, это абсолютно законно. При использовании снимков из новостных лет вообще допустимо просто отсылать к источнику (часть 4 ГК РФ ). Убирают такие картинки только по требованию источника.

Парсинг файлов

Законен на 100%. Так как закачка файлов происходит на обменники, а с них скачивать контент может кто угодно, даже робот. Главное, чтобы содержание файла, который вы выкладываете на сайт, не противоречило закону. Учитывайте потенциальную аудиторию сайта.

Парсинг товаров

См. «Парсинг картинок». Если же речь идёт о содержимом карточек товаров (с их характеристиками), то, как правило, в них содержится информация, предоставляемая производителем, то есть общедоступные данные о товаре. А значит, копирование их вполне законно. Для большей убедительности рекомендуем в карточке менять либо фото, либо её размер.

Парсинг сайтов целикоми парсинг интернет-магазинов

Подразумевается перенос структуры сайта и содержимого (контента). Естественно, это будет не тот же сайт. Различается доменное имя, контактная информация, наименование Вашей компании и т.д. Для уникальности текстов их синонимизируют. Главный объект переноса - понравившаяся клиенту структура. Не рекомендуется копировать сайты «монстров». Но в ситуации с компаниями малого и среднего бизнес перенос бывает вполне оправдан. Клиент должен помнить, что в случае подозрения на нарушение авторских прав владельца первоначального сайта, иск будет предъявлен к нему. Поэтому перед парсингом стоит проанализировать, какие элементы сайта всё же нужно изменить. Помните! Парсинг сайта целиком достаточно распространён, иначе в сети было бы минимум в 20 раз меньше сайтов.

Парсинг телефонных номеров и парсинг E-mail адресов

Номера ГТС находятся в свободном доступе и могут быть опубликованы на любом сайте. Можно парсить без ограничений номера юридических лиц любого типа и номера индивидуальных предпринимателей. Почему? Существуют Единый реестр юридических лиц и Единый реестр индивидуальных предпринимателей. Номера частных лиц можно парсить, если они размещены самими этими лицами в СМИ (к коим относится и интернет). Сегодня подавляющее число людей размещают свои номера телефонов, месенджеров и «мыло» в социальных сетях. Соответственно, заказав парсинг-компании такую базу, любой бизнес получает колоссальную базу потенциальных клиентов. Притом, на абсолютно законных основаниях.

О чём должен помнить бизнесмен, заказывая парсинг?

- Он быстро получает информацию современными и законными способами. Сама суть услуги парсинга подразумевает, что собрать можно только ту информацию, которая находится в открытом доступе в сети Интернет.

- Машины не способны различать объекты, являющиеся защищенными авторским правом, и объекты, которые этим правом не защищены. Но при синонимизации машина создаёт уникальное произведение, являющееся самостоятельным объектом авторского права, которое будет принадлежать покупателю.

- В большинстве случаев для соблюдения интересов правообладателя достаточно делать отсылку на его ресурс с пометкой «Объект будет удалён по требованию правообладателя». Сообщать правообладателю об использовании объекта не обязательно.

- При переработке (рерайтинге) текстов, хоть как-то относящихся к новостным событиям, достаточно сделать пометку об источнике информации. Та же пометка делается относительно иллюстраций к новости (фото, рисунку и т.д.).

- Современный уровень развития авторского права в России не позволяет доказывать в суде факты переноса структуры сайта и синонимизации его содержания, что делает перенос сайта полностью законным.

- За содержание сайта ответственность несёт его владелец, а не компания, наполняющая сайт. Исключений из этого правила в законе нет.